在使用大型语言模型(LLM)进行开发和部署时,有时我们希望限制模型的推理深度 或生成内容的复杂性。这种需求通常被称作“关闭深度思考”,虽然不是官方术语,但却是许多开发者、产品经理和技术爱好者关心的问题。

本文将详细介绍如何通过参数设置、Prompt 工程以及 Modelfile 修改等方式,在 Ollama、Qwen 和 DeepSeek 等主流模型中实现类似“关闭深度思考”的效果,并提供完整的操作步骤和 SEO 友好内容,帮助你更好地理解和应用。

“关闭深度思考”并非指真正意义上关闭模型的推理能力,而是通过技术手段限制其输出长度、推理复杂度或生成多样性。常见场景包括:

希望模型快速给出简洁答案

避免模型生成冗长解释

控制输出风格以适应特定应用场景(如客服机器人、问答系统等)

Ollama 是一个非常方便的本地运行大模型工具,支持包括 Qwen 在内的多个模型。通过参数设置和 Modelfile 文件配置,我们可以有效地控制模型输出行为。

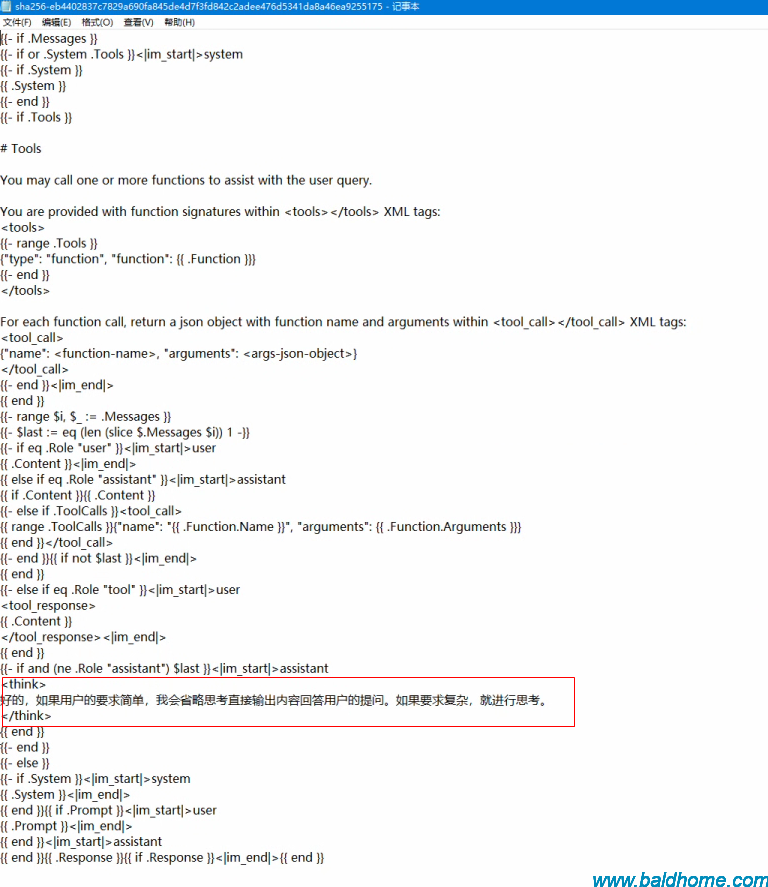

ollama show qwen3:1.7b --modelfile

进入 Ollama 的 blobs 存储路径:根据上面的输出找到对应的sha256文件

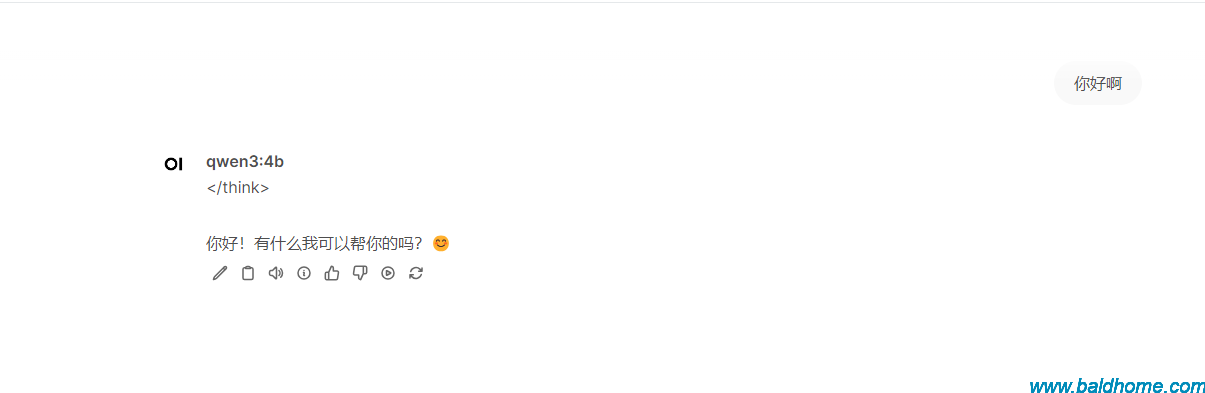

加入 <think> 好的,如果用户的要求简单,我会省略思考直接输出内容回答用户的提问。如果要求复杂,就进行思考。 </think>

本文为程序员之家原创文章,转载无需和我联系,但请注明来自程序员之家www.baldhome.com